Распределение Стьюдента

| Распределение Стьюдента | |

|---|---|

Плотность вероятности Плотность вероятности | |

Функция распределения Функция распределения | |

| Обозначение | [math]\displaystyle{ \mathrm{t}(n) }[/math] |

| Параметры | [math]\displaystyle{ n \gt 0 }[/math] — число степеней свободы |

| Носитель | [math]\displaystyle{ x \in (-\infty; +\infty) }[/math] |

| Плотность вероятности | [math]\displaystyle{ \frac{\Gamma(\frac{n+1}2)} {\sqrt{n\pi}\,\Gamma(\frac{n}2)\,(1+\frac{x^2}n)^{\frac{n+1}2}} }[/math] |

| Функция распределения | [math]\displaystyle{ \frac{1}{2} + {x \Gamma \left( \frac{n+1}2 \right)}\times }[/math] [math]\displaystyle{ \frac{\,_2F_1 \left ( \frac{1}{2},\frac{n+1}2;\frac{3}{2};-\frac{x^2}{n} \right)} {\sqrt{\pi n}\,\Gamma (\frac{n}2)} }[/math] где [math]\displaystyle{ _2F_1 }[/math] — гипергеометрическая функция |

| Математическое ожидание | [math]\displaystyle{ 0 }[/math], если [math]\displaystyle{ n\gt 1 }[/math] |

| Медиана | [math]\displaystyle{ 0 }[/math] |

| Мода | [math]\displaystyle{ 0 }[/math] |

| Дисперсия | [math]\displaystyle{ \frac{n}{n-2} }[/math], если [math]\displaystyle{ n\gt 2 }[/math] |

| Коэффициент асимметрии | [math]\displaystyle{ 0 }[/math], если [math]\displaystyle{ n\gt 3 }[/math] |

| Коэффициент эксцесса | [math]\displaystyle{ \frac{6}{n-4} }[/math], если [math]\displaystyle{ n\gt 4 }[/math] |

| Дифференциальная энтропия |

[math]\displaystyle{ \begin{matrix} \frac{n+1}{2}\left[ \psi(\frac{1+n}{2}) - \psi(\frac{n}{2}) \right] \\[0.5em] + \log{\left[\sqrt{n}B(\frac{n}{2},\frac{1}{2})\right]} \end{matrix} }[/math]

|

| Производящая функция моментов | не определена |

Распределе́ние Стью́дента ([math]\displaystyle{ t }[/math]-распределение) в теории вероятностей — это однопараметрическое семейство абсолютно непрерывных распределений. Уильям Сили Госсет первым опубликовал работы, посвящённые этому распределению, под псевдонимом «Стьюдент».

Распределение Стьюдента играет важную роль в статистическом анализе и используется, например, в t-критерии Стьюдента для оценки статистической значимости разности двух выборочных средних, при построении доверительного интервала для математического ожидания нормальной совокупности при неизвестной дисперсии, а также в линейном регрессионном анализе. Распределение Стьюдента также появляется в байесовском анализе данных, распределённых по нормальному закону.

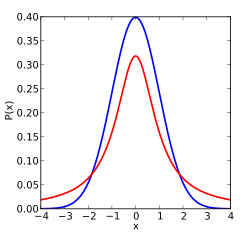

График плотности распределения Стьюдента, как и нормального распределения, является симметричным и имеет вид колокола, но с более «тяжёлыми» хвостами, то есть реализациям случайной величины, имеющей распределение Стьюдента, более свойственно сильно отличаться от математического ожидания. Это делает его важным для понимания статистического поведения определённых типов отношений случайных величин, в которых отклонение в знаменателе увеличено и может производить отдалённые величины, когда знаменатель соотношения близок к нулю.

Распределение Стьюдента — частный случай обобщённого гиперболического распределения.

История и этимология

В статистике t-распределение было впервые получено как апостериорное распределение в 1876 году Фридрихом Гельмертом[1][2][3] и Якобом Люротом[4][5][6].

В англоязычной литературе распределение берёт название из статьи Уильяма Госсета в журнале Пирсона «Биометрика», опубликованной под псевдонимом «Стьюдент»[7][8].

Госсет работал в пивоварне Гиннесс в Дублине, Ирландия, и применял свои знания в области статистики как при варке пива, так и на полях — для выведения самого урожайного сорта ячменя. Исследования были обращены к нуждам пивоваренной компании и проводились на малом количестве наблюдений, что послужило толчком для развития методов, работающих на малых выборках.

Госсету пришлось скрывать свою личность при публикации из-за того, что ранее другой исследователь, работавший на Гиннесс, опубликовал в своих материалах сведения, составлявшие коммерческую тайну компании, после чего Гиннесс запретил своим работникам публикацию любых материалов, независимо от содержавшейся в них информации.

Статья Госсета описывает распределение как «Частотное распределение стандартных отклонений выборок, извлечённых из генеральной совокупности». Оно стало известным благодаря работе Роналда Фишера, который называл распределение «распределением Стьюдента», а величину — буквой t[9].

Определение

Пусть [math]\displaystyle{ Y_0,Y_1,\ldots, Y_n }[/math] — независимые стандартные нормальные случайные величины, такие что [math]\displaystyle{ Y_i \sim \mathcal{N}(0,1),\; i=0,\ldots, n }[/math]. Тогда распределение случайной величины [math]\displaystyle{ t }[/math], где

- [math]\displaystyle{ t = \frac{Y_0}{\sqrt{\frac{1}{n}\sum\limits_{i=1}^n Y_i^2}}, }[/math]

называется распределением Стьюдента с [math]\displaystyle{ n }[/math] степенями свободы [math]\displaystyle{ t \sim \mathrm{t}(n) }[/math].

Это распределение абсолютно непрерывно с плотностью:

- [math]\displaystyle{ f_t(y) = \frac{\Gamma\left(\frac{ n+1}{2}\right)}{\sqrt{ n\pi} \, \Gamma\left(\frac{ n}{2}\right)}\, \left(1+\frac{y^2}{ n}\right)^{-\frac{ n+1}{2}} }[/math],

где [math]\displaystyle{ \Gamma }[/math] — гамма-функция Эйлера. Таким образом:

- [math]\displaystyle{ \frac{\Gamma(\frac{ n+1}{2})} {\sqrt{ n\pi}\,\Gamma(\frac{ n}{2})} = \frac{( n -1)( n -3)\cdots 5 \cdot 3} {2\sqrt{ n}( n -2)( n -4)\cdots 4 \cdot 2\,}, }[/math] для чётных [math]\displaystyle{ n }[/math]

и соответственно

- [math]\displaystyle{ \frac{\Gamma(\frac{ n+1}{2})} {\sqrt{ n\pi}\,\Gamma(\frac{ n}{2})} = \frac{( n -1)( n -3)\cdots 4 \cdot 2} {\pi \sqrt{ n}( n -2)( n -4)\cdots 5 \cdot 3\,}, }[/math] для нечётных [math]\displaystyle{ n }[/math].

Также плотность распределения Стьюдента можно выразить воспользовавшись бета-функцией Эйлера [math]\displaystyle{ \mathrm{B} }[/math]:

- [math]\displaystyle{ f_t(y) = \frac{1}{\sqrt{ n}\,\mathrm{B} (\frac{1}{2}, \frac{ n}{2})} \left(1+\frac{y^2}{ n} \right)^{\!-\frac{ n+1}{2}} }[/math].

График функции плотности t-распределения симметричен, а его форма напоминает форму колокола, как у стандартного нормального распределения, но он ниже и шире.

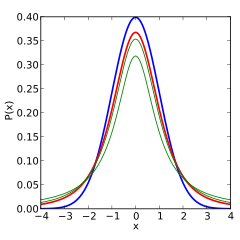

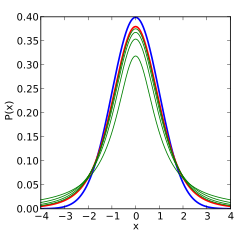

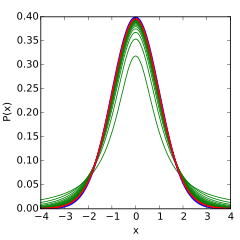

Следующие графики отражают плотность t-распределения при увеличении числа [math]\displaystyle{ n }[/math] степеней свободы. Можно наблюдать как по мере возрастания [math]\displaystyle{ n }[/math], кривая функции плотности все больше напоминает стандартное нормальное распределение.

Функция распределения

Функция распределения может быть выражена через регуляризованную неполную бета-функцию [math]\displaystyle{ I }[/math]. Для [math]\displaystyle{ t \gt 0 }[/math],

- [math]\displaystyle{ F(t) = \int_{-\infty}^t f(u)\,du = 1- \tfrac{1}{2} I_{x(t)}\left(\tfrac{ n}{2}, \tfrac{1}{2}\right), }[/math] где [math]\displaystyle{ x(t) = \frac{ n}{{t^2+ n}}. }[/math] [10]

Для [math]\displaystyle{ t \lt 0 }[/math] значения можно получить в силу симметричности распределения.

Другая формула верна для [math]\displaystyle{ t^2 \lt n }[/math][10]:

- [math]\displaystyle{ \int_{-\infty}^t f(u)\,du =\tfrac{1}{2} + t\frac{\Gamma \left( \tfrac{1}{2}( n+1) \right)} {\sqrt{\pi n}\,\Gamma \left(\tfrac{ n}{2}\right)} {}_2F_1 \left ( \tfrac{1}{2},\tfrac{1}{2}( n+1); \tfrac{3}{2}; -\tfrac{t^2}{ n} \right) }[/math],

где 2F1 является частным случаем гипергеометрической функции.

Частные случаи

- Распределение Стьюдента с одной степенью свободы ([math]\displaystyle{ n = 1 }[/math]) это стандартное распределение Коши.

- Функция распределения: [math]\displaystyle{ F(t) = \tfrac{1}{2} + \tfrac{1}{\pi}\arctan(t) }[/math]

- Плотность вероятности: [math]\displaystyle{ f(t) = \frac{1}{\pi (1+t^2)} }[/math]

- Распределение Стьюдента с двумя степенями свободы ([math]\displaystyle{ n = 2 }[/math]):

- Функция распределения: [math]\displaystyle{ F(t) = \tfrac{1}{2}+\frac{t}{2\sqrt{2+t^2}} }[/math]

- Плотность вероятности: [math]\displaystyle{ f(t) = \frac{1}{\left(2+t^2\right)^{\frac{3}{2}}} }[/math];

- Распределение Стьюдента с тремя степенями свободы ([math]\displaystyle{ n = 3 }[/math]):

- Плотность вероятности: [math]\displaystyle{ f(t) = \frac{6\sqrt{3}}{\pi\left(3+t^2\right)^2} }[/math]

- Распределение Стьюдента с бесконечным числом степеней свободы ([math]\displaystyle{ n = \infty }[/math]):

- Плотность вероятности [math]\displaystyle{ f(t) = \frac{1}{\sqrt{2\pi}} e^{-\frac{t^2}{2}} }[/math]

совпадает с плотностью вероятности стандартного нормального распределения.

Свойства распределения Стьюдента

- Распределение Стьюдента симметрично. В частности если [math]\displaystyle{ t \sim \mathrm{t}(n) }[/math], то [math]\displaystyle{ - t \sim \mathrm{t}(n) }[/math].

- Существуют только моменты порядка [math]\displaystyle{ k \lt n }[/math], и не существуют моменты порядка [math]\displaystyle{ k \ge n }[/math]. При этом все существующие моменты нечетного порядка равны нулю.

- [math]\displaystyle{ \mathbb{E}\left[t^k\right] = 0 }[/math], если [math]\displaystyle{ k }[/math] нечётно;

- [math]\displaystyle{ \mathbb{E}\left[t^k\right] = \frac{1}{\sqrt{\pi}\Gamma\left(\frac{ n}{2}\right)}\left[\Gamma\left(\frac{k+1}{2}\right)\Gamma\left(\frac{ n-k}{2}\right) n^{\frac{k}{2}}\right] }[/math], если [math]\displaystyle{ k }[/math] чётно. В частности,

- Математическое ожидание [math]\displaystyle{ \mathbb{E}[t] = 0 }[/math], если [math]\displaystyle{ n \gt 1 }[/math].

- Дисперсия [math]\displaystyle{ \mathrm{D}[t] = {n \over n - 2} }[/math], если [math]\displaystyle{ n \gt 2 }[/math].

Характеристики

Распределение Стьюдента с [math]\displaystyle{ k }[/math] степенями свободы может быть определено как распределение случайной величины [math]\displaystyle{ T }[/math][10][11]

- [math]\displaystyle{ T=\frac{Z}{\sqrt{V/k}} = Z \sqrt{\frac{k}{V}} }[/math],

где

- Z – случайная величина, имеющая стандартное нормальное распределение [math]\displaystyle{ \mathcal{N}(0,1) }[/math];

- V – случайная величина, имеющая распределение хи-квадрат с [math]\displaystyle{ k }[/math] степенями свободы;

- Z и V — независимые случайные величины .

Пусть, [math]\displaystyle{ X_1, \ldots, X_n }[/math], независимые случайные величины, имеющие нормальное распределение [math]\displaystyle{ \mathcal{N}(\mu, \sigma^2) }[/math],

[math]\displaystyle{ \overline{X}_n = \frac{1}{n}(X_1+\cdots+X_n) }[/math] – выборочное среднее,

- [math]\displaystyle{ S_n^{\;2} = \frac{1}{n-1}\sum_{i=1}^n\left(X_i-\overline{X}_n\right)^2 }[/math] – несмещённая оценка дисперсии.

Тогда случайная величина

- [math]\displaystyle{ V = (n-1)\frac{S_n^2}{\sigma^2} }[/math]

имеет распределение хи-квадрат с [math]\displaystyle{ k = n-1 }[/math] степенями свободы[12].

Случайная величина [math]\displaystyle{ Z = \left(\overline{X}_n-\mu\right)\frac{\sqrt{n}}{\sigma} }[/math] имеет стандартное нормальное распределение, [math]\displaystyle{ Z \sim \mathcal{N}(0,1) }[/math], так как выборочное среднее [math]\displaystyle{ \overline{X}_n }[/math] имеет нормальное распределение [math]\displaystyle{ \mathcal{N}(\mu, \frac{\sigma^2}{n}) }[/math]. Более того, можно показать, что эти две случайные величины (нормальная [math]\displaystyle{ Z }[/math] и хи-квадрат [math]\displaystyle{ V }[/math]) независимы.

Подставим получившиеся величины в величину

- [math]\displaystyle{ T \equiv \frac{Z}{\sqrt{V/k}} = \left(\overline{X}_n-\mu\right)\frac{\sqrt{n}}{S_n} }[/math],

которая имеет распределение Стьюдента и отличается от [math]\displaystyle{ Z }[/math] тем, что стандартное отклонение [math]\displaystyle{ \sigma }[/math] заменено случайной величиной [math]\displaystyle{ S_n }[/math], . Заметим, что неизвестная дисперсия [math]\displaystyle{ \sigma^2 }[/math] не появляется в [math]\displaystyle{ T }[/math], так как она была и в числителе, и в знаменателе. Госсет интуитивно получил плотность вероятности, установленную выше, где [math]\displaystyle{ k }[/math] соответствует [math]\displaystyle{ n-1 }[/math]; Фишер доказал это в 1925 году [9].

Распределение статистики критерия [math]\displaystyle{ T }[/math], зависит от [math]\displaystyle{ k }[/math], но не зависит от μ или σ2, что и делает распределение важным как в теории, так и на практике.

Как возникает t-распределение

Выборочная дисперсия

Распределение Стьюдента возникает в связи с распределением выборочной дисперсии. Пусть [math]\displaystyle{ X_1,\ldots, X_n }[/math] независимые случайные величины, такие что [math]\displaystyle{ X_i \sim \mathrm{N}(\mu, \sigma^2),\; i=1,\ldots, n }[/math]. Обозначим [math]\displaystyle{ \bar{X} }[/math] выборочное среднее этой выборки, а [math]\displaystyle{ S^2 }[/math] её выборочную дисперсию. Тогда

- [math]\displaystyle{ \frac{\bar{X} - \mu}{S / \sqrt{n}} \sim \mathrm{t}(n-1) }[/math].

С этим фактом связано использование распределения Стьюдента в статистике для точечного оценивания, построения доверительных интервалов и тестирования гипотез, касающихся неизвестного среднего выборки из нормального распределения.

Байесовская статистика

В байесовской статистике, нецентральное t-распределение встречается как маргинальное распределение коэффициента [math]\displaystyle{ m }[/math] нормального распределения [math]\displaystyle{ \mathcal{N}(m, \sigma^2) }[/math].

Зависимость неизвестной дисперсии выражается через:

- [math]\displaystyle{ \begin{align} p(\mu\mid D, I) = & \int p(\mu,\sigma^2\mid D, I) \; d \sigma^2 = \int p(\mu\mid D, \sigma^2, I) \; p(\sigma^2\mid D, I) \; d \sigma^2 \end{align} }[/math]

где [math]\displaystyle{ D }[/math] – это данные {xi}, а [math]\displaystyle{ I }[/math] представляет собой любую другую информацию, которая могла быть использована для создания модели.

Когда данные неинформативны из теоремы Байеса следует

- [math]\displaystyle{ \begin{align} p(\mu\mid D, \sigma^2, I) \sim & N(\bar{x}, \frac{\sigma^2}{n}) \end{align} }[/math]

- [math]\displaystyle{ \begin{align} p(\sigma^2 \mid D, I) \sim & \operatorname{Scale-inv-\chi^2}( n, s^2) \end{align} }[/math]

нормальное распределение и масштабированное обратное хи-квадрат распределение, где

- [math]\displaystyle{ s^2 = \sum \frac{(x_i - \bar{x})^2}{n-1} }[/math].

Маргинализованный интеграл в таком случае имеет вид

- [math]\displaystyle{ \begin{align} p(\mu|D, I) &\propto \int_0^{\infty} \frac{1}{\sqrt{\sigma^2}} \exp \left(-\frac{1}{2\sigma^2} n(\mu - \bar{x})^2\right) \;\cdot\; \sigma^{- n-2}\exp(- n s^2/2 \sigma^2) \; d\sigma^2 \\ &\propto \int_0^{\infty} \sigma^{- n-3} \exp \left(-\frac{1}{2 \sigma^2} \left(n(\mu - \bar{x})^2 + n s^2\right) \right) \; d\sigma^2 \end{align} }[/math]

после замены [math]\displaystyle{ z = A / 2\sigma^2 }[/math], где [math]\displaystyle{ A = n(\mu - \bar{x})^2 + n s^2 }[/math],

получим [math]\displaystyle{ dz = -\frac{A}{2 \sigma^4} d \sigma^2 }[/math]

и оценку [math]\displaystyle{ p(\mu|D, I) \propto \; A^{-\frac{ n + 1}{2}} \int_0^\infty z^{( n-1)/2} \exp(-z) \, dz }[/math]

[math]\displaystyle{ \int_0^\infty z^{( n-1)/2} \exp(-z) \, dz }[/math] теперь стандартный Гамма интеграл, который оценивается константой

[math]\displaystyle{ \begin{align}p(\mu\mid D, I) \propto & \; A^{-\frac{ n + 1}{2}} \propto & \left( 1 + \frac{n(\mu - \bar{x})^2}{ n s^2} \right)^{-\frac{ n + 1}{2}} \end{align} }[/math]

это нестандартизированное t-распределение.

С помощью замены [math]\displaystyle{ t = \frac{\mu - \bar{x}}{s / \sqrt{n}} }[/math] получаем стандартизированное t-распределение.

Дифференцирование выше было представлено для случая неинформативной априорной вероятности для [math]\displaystyle{ \scriptstyle{\mu} }[/math] и [math]\displaystyle{ \scriptstyle{\sigma^2} }[/math]; но очевидно, что любая априорная вероятность, ведет к смешению нормального распределения и масштабированного обратного хи-квадрат распределение, что нецентральному t-распределению с масштабированием и смещением на [math]\displaystyle{ \scriptstyle{P(\mu|D,I)} }[/math], параметр масштабирования [math]\displaystyle{ \scriptstyle{\frac{S^2}{n}} }[/math] будет в находиться под влиянием априорной информации и данных, а не только данных, как в примере выше.

Обобщения распределения Стьюдента

Нестандартизированное распределение Стьюдента

Распределение Стьюдента можно обобщить до семейства функций с тремя параметрами, включающими коэффициент сдвига [math]\displaystyle{ \mu }[/math] и коэффициент масштаба [math]\displaystyle{ \sigma }[/math], через отношение

- [math]\displaystyle{ X = \mu + \sigma T }[/math]

или

- [math]\displaystyle{ T = \frac{X - \mu}{ \sigma} }[/math],

где [math]\displaystyle{ \frac{x - \mu}{ \sigma} }[/math] классическое распределение Стьюдента с [math]\displaystyle{ n }[/math] степенями свободы.

Плотность нестандартизированного распределения Стьюдента представляет собой репараметризованное распределение Пирсона типа VII и определяется следующим выражением[13]

- [math]\displaystyle{ p(x\mid n,\mu,\sigma) = \frac{\Gamma(\frac{ n + 1}{2})}{\Gamma(\frac{ n}{2})\sqrt{\pi n}\sigma} \left(1+\frac{1}{ n}\left(\frac{x-\mu}{\sigma}\right)^2\right)^{-\frac{ n+1}{2}} }[/math]

Здесь [math]\displaystyle{ \sigma }[/math] не является стандартным отклонением, как в нормальном распределении, это, вообще говоря, другой параметр масштаба. Однако при [math]\displaystyle{ n \to \infty }[/math] плотность распределения Пирсона типа VII стремится к плотности нормального распределения со стандартным отклонением [math]\displaystyle{ \sigma }[/math].

В байесовском выводе предельное распределение неизвестного среднего значения [math]\displaystyle{ \mu }[/math] выше чем [math]\displaystyle{ \sigma }[/math], и соответствует [math]\displaystyle{ \scriptstyle{s/\sqrt{n}} }[/math], где

- [math]\displaystyle{ s^2 = \sum \frac{(x_i - \bar{x})^2}{n-1}. }[/math]

[math]\displaystyle{ \operatorname{E}(X) = \mu }[/math] для [math]\displaystyle{ n \gt 1 }[/math],

[math]\displaystyle{ \text{var}(X) = \sigma^2\frac{ n}{ n-2} }[/math] для [math]\displaystyle{ n \gt 2 }[/math]

[math]\displaystyle{ \text{mode}(X) = \mu. }[/math]

Такое распределение является результатом комбинации распределения Гаусса (нормального распределения) со средним значением [math]\displaystyle{ \mu }[/math] и неизвестной дисперсией, с обратным гамма-распределением, с дисперсией, имеющей параметры [math]\displaystyle{ a = n/2 }[/math] и [math]\displaystyle{ b = n\sigma^2/2 }[/math]. Другими словами, предполагается, что случайная величина X обладает нормальным распределением с неизвестной дисперсией, распределенной как обратная гамма, а затем дисперсия исключается. Такое свойство полезно из-за того, что обратное гамма-распределение – это сопряженное априорное распределение дисперсии распределения Гаусса, именно поэтому нестандартизированное распределение Стьюдента естественным образом возникает во многих байесовских задачах.

Эквивалентно, это распределение является результатом комбинации распределения Гаусса с масштабированным обратным хи-квадрат распределением с параметрами [math]\displaystyle{ n }[/math] and [math]\displaystyle{ \sigma^2 }[/math]. Масштабированное обратное хи-квадрат распределение - точно то же самое распределение, что и обратное гамма-распределение, но с другой параметризацией, а именно [math]\displaystyle{ n = 2a, \sigma^2 = b/a }[/math].

Альтернативная параметризация на основании обратного параметра масштабирования λ[14] (аналогично тому, как мера точности обратна дисперсии), определенная отношением [math]\displaystyle{ \lambda = \frac{1}{\sigma^2} }[/math],

тогда плотность определяется как

- [math]\displaystyle{ p(x| n,\mu,\lambda) = \frac{\Gamma(\frac{ n + 1}{2})}{\Gamma(\frac{ n}{2})} \left(\frac{\lambda}{\pi n}\right)^{\frac{1}{2}} \left(1+\frac{\lambda(x-\mu)^2}{ n}\right)^{-\frac{ n+1}{2}}. }[/math]

Свойства:

[math]\displaystyle{ \operatorname{E}(X) = \mu }[/math] для [math]\displaystyle{ n \gt 1 }[/math],

[math]\displaystyle{ \text{var}(X) = \frac{1}{\lambda}\frac{ n}{ n-2} }[/math] для [math]\displaystyle{ n \gt 2 }[/math]

[math]\displaystyle{ \text{mode}(X) = \mu. }[/math]

Это распределение является результатом комбинации распределения Гаусса со средним [math]\displaystyle{ \mu }[/math] и неизвестной мерой точности (обратной дисперсии), с гамма-распределением с параметрами [math]\displaystyle{ a = n/2 }[/math] and [math]\displaystyle{ b = n/(2\lambda) }[/math]. Другими словами, предполагается, что случайная величина X обладает нормальным распределением с неизвестной гамма-распределённой мерой точности.

Нецентральное распределение Стьюдента

Нецентральное распределение Стьюдента, это один способов обобщения стандартного распределения Стьюдента, включающий дополнительный коэффициент сдвига (параметр нецентральности) [math]\displaystyle{ \mu }[/math].

[math]\displaystyle{ (Z+\mu)\sqrt{\frac{ n}{V}}. }[/math]

В нецентральном распределении Стьюдента медиана не совпадает с модой, т.е. оно не симметрично (в отличие от нестандартизированного).

Это распределение важно для изучения статистической мощности t-критерия Стьюдента.

Дискретное распределение Стьюдента

Дискретное распределение Стьюдента имеет следующую функцию распределения с r пропорциональным:[15]

- [math]\displaystyle{ \prod_{j=1}^k \frac{1}{(r+j+a)^2+b^2} \quad \quad r=\ldots, -1, 0, 1, \ldots . }[/math]

Где a, b, и k – параметры. Такое распределение возникает при работе с системами из дискретных распределений, таких как распределение Пирсона.[16]

Связь с другими распределениями

- Распределение Стьюдента является распределением Пирсона типа VII[17].

- Распределение Стьюдента с одной степенью свободы ([math]\displaystyle{ n = 1 }[/math]) это стандартное распределение Коши: [math]\displaystyle{ \mathrm{t}(1) \equiv \mathrm{C}(0,1) }[/math].

- Распределение Стьюдента сходится к стандартному нормальному при [math]\displaystyle{ n \to \infty }[/math]. Пусть дана последовательность случайных величин [math]\displaystyle{ \{t_n\}_{n=1}^{\infty} }[/math], где [math]\displaystyle{ t_n \sim \mathrm{t}(n),\; n \in \mathbb{N} }[/math]. Тогда: [math]\displaystyle{ t_n \to \mathcal{N}(0,1) }[/math] по распределению при [math]\displaystyle{ n \to \infty }[/math].

- Квадрат случайной величины, имеющей распределение Стьюдента, также имеет распределение Фишера. Пусть [math]\displaystyle{ t \sim \mathrm{t}(n) }[/math]. Тогда: [math]\displaystyle{ t^2 \sim \mathrm{F}(1,n) }[/math].

Обобщение распределения Гаусса

Мы можем получить выборку с t-распределением, взяв отношение величин из нормального распределения и квадратный корень из распределения хи-квадрат.

где [math]\displaystyle{ X_0,X_1,\ldots, X_n }[/math] — независимые стандартные нормальные случайные величины, такие что [math]\displaystyle{ X_i \sim \mathcal{N}(0,1),\; i=0,\ldots, n }[/math]

[math]\displaystyle{ t = \frac{X_0}{\sqrt{\frac{1}{n}\sum\limits_{i=1}^n X_i^2}}. }[/math]

Если мы вместо нормального распределения, возьмём например, Ирвин-Холл, получится симметричное распределение с 4 параметрами, которое включает в себя нормальное, равномерное, треугольное, а также распределения Стьюдента и Коши; таким образом, это обобщение более гибкое, чем многие другие симметричные обобщения распределения Гаусса.

Применение распределения Стьюдента

Проверка гипотезы

Некоторые статистики могут иметь распределение Стьюдента на выборках небольшого размера, поэтому распределение Стьюдента формирует основу критериев значимости. Например, тест ранговой корреляции Спирмена ρ, в нулевом случае (нулевая корреляция) хорошо аппроксимируется распределением Стьюдента при размере выборки больше 20.

Построение доверительного интервала

Распределение Стьюдента может быть использовано для оценки того, насколько вероятно, что истинное среднее находится в каком-либо заданном диапазоне.

Предположим, что число A выбрано так, что

[math]\displaystyle{ \Pr(-A \lt T \lt A)=0.9 }[/math].

Тогда T имеет t-распределение с n–1 степенями свободы. В силу симметрии распределения, это равноценно утверждению, что А удовлетворяет

[math]\displaystyle{ \Pr(T \lt A) = 0.95, }[/math] или [math]\displaystyle{ A=t_{(0.05,n-1)} }[/math], тогда

[math]\displaystyle{ \Pr \left (-A \lt \frac{\overline{X}_n - \mu}{\frac{S_n}{\sqrt{n}}} \lt A \right)=0.9, }[/math]

что эквивалентно

[math]\displaystyle{ \Pr\left(\overline{X}_n - A \frac{S_n}{\sqrt{n}} \lt \mu \lt \overline{X}_n + A\frac{S_n}{\sqrt{n}}\right) = 0.9. }[/math]

таким образом, интервал с доверительным пределом в точках [math]\displaystyle{ \overline{X}_n\pm A\frac{S_n}{\sqrt{n}} }[/math] — это 90% доверительный интервал для μ. Следовательно, если мы находим среднее множества наблюдений (нормально распределённых), мы можем использовать распределение Стьюдента, чтобы определить, включают ли доверительные пределы по этому среднему какое-либо теоретически предсказанное значение, например, значение, предсказанное, исходя из нулевой гипотезы.

Такой подход применяется в t-критерии Стьюдента: если разность между средними значениями выборок из двух нормальных распределений сама может быть нормально распределена, распределение Стьюдента может быть использовано для исследования того, можно ли с большой долей вероятности полагать эту разность равной нулю.

Для нормально распределённых выборок односторонний (1−a) верхний доверительный предел (UCL) среднего значения равен

[math]\displaystyle{ \mathrm{UCL}_{1-a} = \overline{X}_n + t_{a,n-1}\frac{S_n}{\sqrt{n}} }[/math].

Полученный в результате верхний доверительный предел будет наибольшим средним значением для данного доверительного интервала и размера выборки. Другими словами, если [math]\displaystyle{ \overline{X}_n }[/math] среднее значение множества наблюдений, вероятность того, что среднее значение распределения уступает [math]\displaystyle{ \mathrm{UCL}_{1-n} }[/math] равна уровню значимости 1–a.

Построение интервала-предиктора

Распределение Стьюдента может быть использовано для получения интервала-предиктора для ненаблюдаемой выборки из нормального распределения с неизвестным средним и дисперсией.

В байесовской статистике

Распределение Стьюдента, особенно нецентральное, часто возникает в байесовской статистике как результат связи с нормальным распределением.

Действительно, если нам неизвестна дисперсия нормально распределенной случайной величины, но известно сопряженное априорное распределение, можно будет подобрать такое гамма-распредение, что полученные в результате величины будут обладать распределением Стьюдента.

Эквивалентные конструкции с теми же результатами включают сопряжённое масштабированное обратное хи-квадратное распределение. Если некорректное априорное распределение, пропорциональное [math]\displaystyle{ \sigma^2 }[/math], расположено над дисперсией, то также возникает распределение Стьюдента. Это происходит независимо от того, известно ли среднее нормально распределенной величины, распределённое с сопряжённым априорным распределением, или нет.

Параметрическое моделирование, устойчивое к нарушениям исходных предпосылок

Распределение Стьюдента часто используется в качестве альтернативы нормальному распределению для модели данных.[18] Это происходит из-за того, что довольно часто настоящие данные имеют более тяжелые хвосты, чем позволяет нормальное распределение. Классический подход заключается в определении выбросов и их исключении (или понижении их веса). Однако не всегда легко определить выброс (особенно в задачах с большой размерностью), и распределение Стьюдента является естественным выбором, обеспечивающим параметрический подход к робастной статистике.

Ланж и другие исследовали использование распределения Стьюдента для робастного (устойчивого к нарушениям исходных предпосылок) моделирования данных. Байесовский расчет обнаруживается у Гельмана и др.

Количество степеней свободы контролирует эксцесс распределения и коррелируется с параметром масштабирования.

Некоторые другие свойства распределения Стьюдента

Пусть, [math]\displaystyle{ A(t| n) }[/math] – интеграл функции плотности вероятности Стьюдента, [math]\displaystyle{ F(t) }[/math] – вероятность того, что значение t, меньше, чем значение, рассчитанное по данным наблюдений.

Функция [math]\displaystyle{ A(t| n) }[/math] может быть использована для тестировании того, является ли разница между средними значениями двух наборов данных взятых из одной совокупности, статистически значимой, это достигается путём вычисления соответствующего значения t и вероятности его возникновения.

Это используется например, в T-критерии Стьюдента. Для t-распределения с [math]\displaystyle{ n }[/math] степенями свободы, [math]\displaystyle{ A(t| n) }[/math] - вероятность того, что t будет меньше наблюдаемого значения, если два средних значения были одинаковыми. Его можно легко вычислить из кумулятивной функции распределения [math]\displaystyle{ F_{ n}(t) }[/math] распределения Стьюдента:

- [math]\displaystyle{ A(t| n) = F_ n(t) - F_ n(-t) = 1 - I_{\frac{ n}{ n +t^2}}\left(\frac{ n}{2},\frac{1}{2}\right), }[/math]

где Ix - регуляризированная неполная бета функция (a, b).

При статистической проверки гипотез эта функция используется для построения р-значения.

Выборка по методу Монте-Карло

Есть разные подходы к получению случайных величин из распределения Стьюдента. Всё зависит от того, требуются независимые выборки, или они могут быть построены путём применения обратной функции распределения над выборкой с однородным распределением.

В случае с независимой выборкой легко применить расширение метода Бокса-Мюллера в его полярной (тригонометрической) форме[19]. Преимущество этого метода в том, что он одинаково относится ко всем положительным степеням свободы [math]\displaystyle{ n }[/math], в то время как многие другие методы не будут работать, если [math]\displaystyle{ n }[/math] близка к нулю.[19]

Плотность распределения Стьюдента через решение дифференциального уравнения

Плотность распределения Стьюдента можно получить, решив следующее дифференциальное уравнение:

[math]\displaystyle{ \left\{\begin{array}{l} \left( n+x^2\right) f'(x)+( n +1) x f(x)=0, \\ f(1)=\frac{ n^{ n/2} ( n +1)^{-\frac{ n}{2}-\frac{1}{2}}}{B\left(\frac{ n}{2}, \frac{1}{2}\right)} \end{array}\right\} }[/math]

Процентили

Таблицы значений

Многие учебники по статистике включают в себя таблицы распределения Стьюдента.

В наши дни лучший способ узнать полностью точное критическое значение t или кумулятивную вероятность — это использование статистической функции, встроенной в электронные таблицы (Office Excel, OpenOffice Calc и т.д.), или интерактивного веб-калькулятора. Нужные функции электронных таблиц — TDIST и TINV.

Таблица ниже включает в себя значения некоторых значений для распределений Стьюдента с v степенями свободы для ряда односторонних или двусторонних критических областей.

В качестве примера того, как читать эту таблицу, возьмём четвёртый ряд, который начинается с 4; это означает, что v, количество степеней свободы, равно 4 (и если мы работаем, как это показано выше, с n величин с фиксированной суммой, то n = 5). Возьмём пятое значение в колонке 95% для односторонних(90% для двусторонних). Значение это равно "2.132". Значит, вероятность, что T меньше 2.132 равна 95% или Pr(−∞ <T< 2.132) = 0.95; это также означает, что Pr(−2.132 <T< 2.132) = 0.9.

Это может быть вычислено по симметрии распределения,

- Pr(T < −2.132) = 1 − Pr(T > −2.132) = 1 − 0.95 = 0.05,

получаем

- Pr(−2.132 < T < 2.132) = 1 − 2(0.05) = 0.9.

Обратите внимание, что последний ряд также даёт критические точки: распределение Стьюдента с бесконечным количеством степеней – это нормальное распределение.

Первая колонка отображает число степеней свободы.

| односторонний | 75% | 80% | 85% | 90% | 95% | 97.5% | 99% | 99.5% | 99.75% | 99.9% | 99.95% |

|---|---|---|---|---|---|---|---|---|---|---|---|

| двусторонний | 50% | 60% | 70% | 80% | 90% | 95% | 98% | 99% | 99.5% | 99.8% | 99.9% |

| 1 | 1.000 | 1.376 | 1.963 | 3.078 | 6.314 | 12.71 | 31.82 | 63.66 | 127.3 | 318.3 | 636.6 |

| 2 | 0.816 | 1.080 | 1.386 | 1.886 | 2.920 | 4.303 | 6.965 | 9.925 | 14.09 | 22.33 | 31.60 |

| 3 | 0.765 | 0.978 | 1.250 | 1.638 | 2.353 | 3.182 | 4.541 | 5.841 | 7.453 | 10.21 | 12.92 |

| 4 | 0.741 | 0.941 | 1.190 | 1.533 | 2.132 | 2.776 | 3.747 | 4.604 | 5.598 | 7.173 | 8.610 |

| 5 | 0.727 | 0.920 | 1.156 | 1.476 | 2.015 | 2.571 | 3.365 | 4.032 | 4.773 | 5.893 | 6.869 |

| 6 | 0.718 | 0.906 | 1.134 | 1.440 | 1.943 | 2.447 | 3.143 | 3.707 | 4.317 | 5.208 | 5.959 |

| 7 | 0.711 | 0.896 | 1.119 | 1.415 | 1.895 | 2.365 | 2.998 | 3.499 | 4.029 | 4.785 | 5.408 |

| 8 | 0.706 | 0.889 | 1.108 | 1.397 | 1.860 | 2.306 | 2.896 | 3.355 | 3.833 | 4.501 | 5.041 |

| 9 | 0.703 | 0.883 | 1.100 | 1.383 | 1.833 | 2.262 | 2.821 | 3.250 | 3.690 | 4.297 | 4.781 |

| 10 | 0.700 | 0.879 | 1.093 | 1.372 | 1.812 | 2.228 | 2.764 | 3.169 | 3.581 | 4.144 | 4.587 |

| 11 | 0.697 | 0.876 | 1.088 | 1.363 | 1.796 | 2.201 | 2.718 | 3.106 | 3.497 | 4.025 | 4.437 |

| 12 | 0.695 | 0.873 | 1.083 | 1.356 | 1.782 | 2.179 | 2.681 | 3.055 | 3.428 | 3.930 | 4.318 |

| 13 | 0.694 | 0.870 | 1.079 | 1.350 | 1.771 | 2.160 | 2.650 | 3.012 | 3.372 | 3.852 | 4.221 |

| 14 | 0.692 | 0.868 | 1.076 | 1.345 | 1.761 | 2.145 | 2.624 | 2.977 | 3.326 | 3.787 | 4.140 |

| 15 | 0.691 | 0.866 | 1.074 | 1.341 | 1.753 | 2.131 | 2.602 | 2.947 | 3.286 | 3.733 | 4.073 |

| 16 | 0.690 | 0.865 | 1.071 | 1.337 | 1.746 | 2.120 | 2.583 | 2.921 | 3.252 | 3.686 | 4.015 |

| 17 | 0.689 | 0.863 | 1.069 | 1.333 | 1.740 | 2.110 | 2.567 | 2.898 | 3.222 | 3.646 | 3.965 |

| 18 | 0.688 | 0.862 | 1.067 | 1.330 | 1.734 | 2.101 | 2.552 | 2.878 | 3.197 | 3.610 | 3.922 |

| 19 | 0.688 | 0.861 | 1.066 | 1.328 | 1.729 | 2.093 | 2.539 | 2.861 | 3.174 | 3.579 | 3.883 |

| 20 | 0.687 | 0.860 | 1.064 | 1.325 | 1.725 | 2.086 | 2.528 | 2.845 | 3.153 | 3.552 | 3.850 |

| 21 | 0.686 | 0.859 | 1.063 | 1.323 | 1.721 | 2.080 | 2.518 | 2.831 | 3.135 | 3.527 | 3.819 |

| 22 | 0.686 | 0.858 | 1.061 | 1.321 | 1.717 | 2.074 | 2.508 | 2.819 | 3.119 | 3.505 | 3.792 |

| 23 | 0.685 | 0.858 | 1.060 | 1.319 | 1.714 | 2.069 | 2.500 | 2.807 | 3.104 | 3.485 | 3.767 |

| 24 | 0.685 | 0.857 | 1.059 | 1.318 | 1.711 | 2.064 | 2.492 | 2.797 | 3.091 | 3.467 | 3.745 |

| 25 | 0.684 | 0.856 | 1.058 | 1.316 | 1.708 | 2.060 | 2.485 | 2.787 | 3.078 | 3.450 | 3.725 |

| 26 | 0.684 | 0.856 | 1.058 | 1.315 | 1.706 | 2.056 | 2.479 | 2.779 | 3.067 | 3.435 | 3.707 |

| 27 | 0.684 | 0.855 | 1.057 | 1.314 | 1.703 | 2.052 | 2.473 | 2.771 | 3.057 | 3.421 | 3.690 |

| 28 | 0.683 | 0.855 | 1.056 | 1.313 | 1.701 | 2.048 | 2.467 | 2.763 | 3.047 | 3.408 | 3.674 |

| 29 | 0.683 | 0.854 | 1.055 | 1.311 | 1.699 | 2.045 | 2.462 | 2.756 | 3.038 | 3.396 | 3.659 |

| 30 | 0.683 | 0.854 | 1.055 | 1.310 | 1.697 | 2.042 | 2.457 | 2.750 | 3.030 | 3.385 | 3.646 |

| 40 | 0.681 | 0.851 | 1.050 | 1.303 | 1.684 | 2.021 | 2.423 | 2.704 | 2.971 | 3.307 | 3.551 |

| 50 | 0.679 | 0.849 | 1.047 | 1.299 | 1.676 | 2.009 | 2.403 | 2.678 | 2.937 | 3.261 | 3.496 |

| 60 | 0.679 | 0.848 | 1.045 | 1.296 | 1.671 | 2.000 | 2.390 | 2.660 | 2.915 | 3.232 | 3.460 |

| 80 | 0.678 | 0.846 | 1.043 | 1.292 | 1.664 | 1.990 | 2.374 | 2.639 | 2.887 | 3.195 | 3.416 |

| 100 | 0.677 | 0.845 | 1.042 | 1.290 | 1.660 | 1.984 | 2.364 | 2.626 | 2.871 | 3.174 | 3.390 |

| 120 | 0.677 | 0.845 | 1.041 | 1.289 | 1.658 | 1.980 | 2.358 | 2.617 | 2.860 | 3.160 | 3.373 |

| ∞ | 0.674 | 0.842 | 1.036 | 1.282 | 1.645 | 1.960 | 2.326 | 2.576 | 2.807 | 3.090 | 3.291 |

Например, если нам дана выборка с выборочной дисперсией 2 и выборочным средним 10, взятая из выборочного набора 11 (10 степеней свободы), используя формулу

[math]\displaystyle{ \overline{X}_n\pm A\frac{S_n}{\sqrt{n}}. }[/math]

Мы можем определить с 90% уровнем доверия, что истинное среднее таково:

[math]\displaystyle{ 10+1.37218 \frac{\sqrt{2}}{\sqrt{11}}=10.58510, }[/math]

(то есть, в среднем, в 90% случаев верхний предел превышает истинное среднее)

и, всё также с 90% уверенностью, мы находим истинное среднее значение, превышающее

[math]\displaystyle{ 10-1.37218 \frac{\sqrt{2}}{\sqrt{11}}=9.41490. }[/math]

(В среднем, в 90% случаев нижний предел меньше истинного среднего)

Так что с 80% уверенностью (1-2*(1-90%) = 80%), мы находим истинное значение, лежащее в интервале

[math]\displaystyle{ \left(10-1.37218 \frac{\sqrt{2}}{\sqrt{11}}, 10+1.37218 \frac{\sqrt{2}}{\sqrt{11}}\right) = \left(9.41490, 10.58510\right). }[/math]

Другими словами, в 80% случаев истинное среднее ниже верхнего предела и выше нижнего предела.

Это не эквивалентно утверждению, что с 80% вероятностью истинное среднее лежит между определенной парой верхних и нижних пределов.

Обобщение

Обобщением распределения Стьюдента является обобщённое гиперболическое распределение.

Примечания

- ↑ Helmert, F. R. (1875). "Über die Bestimmung des wahrscheinlichen Fehlers aus einer endlichen Anzahl wahrer Beobachtungsfehler". Z. Math. Phys., 20, 300–3.

- ↑ Helmert, F. R. (1876a). "Über die Wahrscheinlichkeit der Potenzsummen der Beobachtungsfehler und uber einige damit in Zusammenhang stehende Fragen". Z. Math. Phys., 21, 192–218.

- ↑ Helmert, F. R. (1876b). "Die Genauigkeit der Formel von Peters zur Berechnung des wahrscheinlichen Beobachtungsfehlers directer Beobachtungen gleicher Genauigkeit", Astron. Nachr., 88, 113–32.

- ↑ Lüroth, J. Vergleichung von zwei Werten des wahrscheinlichen Fehlers (нем.) // Astron. Nachr. : magazin. — 1876. — Bd. 87, Nr. 14. — S. 209—220. — doi:10.1002/asna.18760871402. — .

- ↑ Pfanzagl, J.; Sheynin, O. A forerunner of the t-distribution (Studies in the history of probability and statistics XLIV) (англ.) // Biometrika : journal. — 1996. — Vol. 83, no. 4. — P. 891—898. — doi:10.1093/biomet/83.4.891.

- ↑ Sheynin, O. Helmert’s work in the theory of errors (англ.) // Arch. Hist. Exact Sci. : journal. — 1995. — Vol. 49. — P. 73—104. — doi:10.1007/BF00374700.

- ↑ “Student” [William Sealy Gosset]. The probable error of a mean (англ.) // Biometrika : journal. — 1908. — March (vol. 6, no. 1). — P. 1—25. — doi:10.1093/biomet/6.1.1.

- ↑ “Student” (William Sealy Gosset), original Biometrika paper as a scan Архивная копия от 5 марта 2016 на Wayback Machine

- ↑ 9,0 9,1 Рональд Фишер. Applications of “Student’s” distribution (англ.) // metron. — 1925. — Vol. 5. — P. 90—104. Архивировано 5 марта 2016 года.

- ↑ 10,0 10,1 10,2 Johnson, N.L., Kotz, S., Balakrishnan, N. глава 28 // Continuous Univariate Distributions, Volume 2, 2nd Edition.. — 1995. — ISBN 0-471-58494-0.

- ↑ Hogg & Craig (1978, Sections 4.4 and 4.8.)

- ↑ W. G. Cochran. The distribution of quadratic forms in a normal system, with applications to the analysis of covariance // Mathematical Proceedings of the Cambridge Philosophical Society. — 1934-04-01. — Т. 30, вып. 02. — С. 178—191. — ISSN 1469-8064. — doi:10.1017/S0305004100016595.

- ↑ Simon Jackman. Bayesian Analysis for the Social Sciences. — Wiley. — 2009. — С. 507.

- ↑ Bishop C.M. Pattern recognition and machine learning. — Springer. — 2006.

- ↑ Ord, J.K. (1972) Families of Frequency Distributions, Griffin. ISBN 0-85264-137-0 (Table 5.1)

- ↑ Ord, J.K. (1972) Families of Frequency Distributions, Griffin. ISBN 0-85264-137-0 (Chapter 5)

- ↑ Королюк, 1985, с. 134.

- ↑ Kenneth L. Lange, Roderick J. A. Little, Jeremy M. G. Taylor. Robust Statistical Modeling Using the t Distribution // Journal of the American Statistical Association. — 1989-12-01. — Т. 84, вып. 408. — С. 881—896. — ISSN 0162-1459. — doi:10.1080/01621459.1989.10478852.

- ↑ 19,0 19,1 Ralph W. Bailey. Polar Generation of Random Variates with the t-Distribution // Mathematics of Computation. — 1994-01-01. — Т. 62, вып. 206. — С. 779—781. — doi:10.2307/2153537. Архивировано 3 апреля 2016 года.

Литература

- Королюк В. С., Портенко Н. И., Скороход А. В., Турбин А. Ф. Справочник по теории вероятностей и математической статистике. — М.: Наука, 1985. — 640 с.